摘要:本文介绍了Spark的最新版本及其安装与使用指南。读者可以通过本文了解如何安装Spark最新版本,并了解如何使用该版本进行数据处理和分析。本文提供了详细的步骤和说明,帮助读者快速上手使用Spark,并充分利用其强大的计算能力和灵活性。

准备工作

下载和安装Spark最新版本

配置Spark

运行Spark

学习使用Spark

进阶使用

注意事项

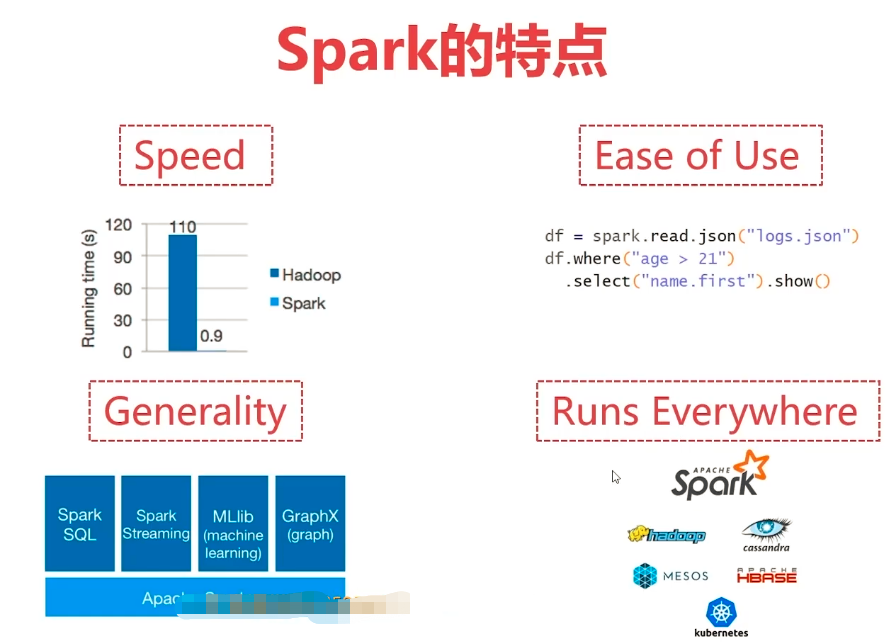

Apache Spark 是一个大规模数据处理引擎,能够处理和分析大数据,随着技术的不断发展,Spark也在不断更新版本,带来许多新特性和优化,本指南将引领您完成Spark最新版本的安装、配置和使用,无论您是初学者还是进阶用户。

准备工作

1、系统要求:确保您的操作系统支持Spark最新版本,并满足最低硬件配置要求。

2、软件环境:安装Java,因为Spark运行在Java虚拟机上。

3、网络环境:确保可以访问互联网,以便下载和更新Spark。

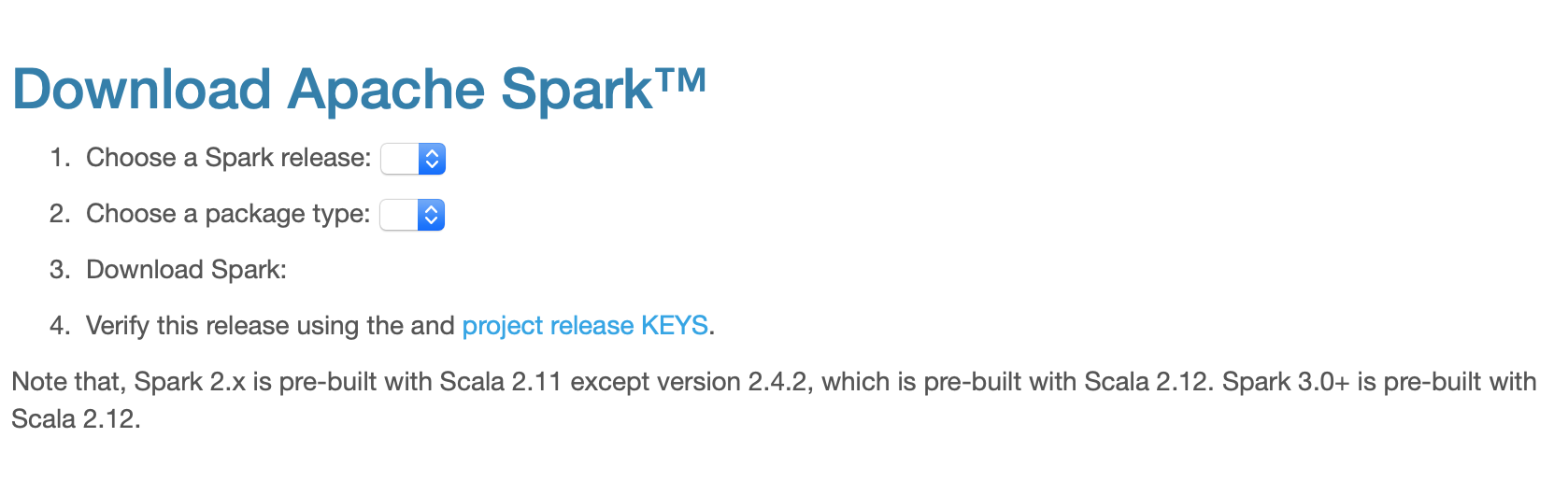

下载和安装Spark最新版本

1、访问Apache Spark官网,找到“下载”或“Download”栏目。

2、选择适合您操作系统的版本,如Windows、Linux或Mac。

3、下载完成后,将安装包解压缩到指定目录。

在Windows上安装Spark:

1、下载Spark安装包,并将其解压缩到C:\spark目录。

2、设置环境变量,将Spark的bin目录添加到系统PATH中。

配置Spark

1、配置环境变量:设置Spark_HOME环境变量,指向您安装Spark的目录。

2、配置Python(如果使用Spark Python API):确保Python环境已安装,并将Python的bin目录添加到系统PATH中。

3、根据需求调整Spark的配置参数,如内存、执行器等。

配置环境变量(Windows):

1、右键点击“计算机”,选择“属性”,然后点击“高级系统设置”。

2、点击“环境变量”,在系统变量部分点击“新建”,变量名为“Spark_HOME”,变量值为您的Spark安装目录。

3、点击“确定”保存设置。

运行Spark

1、打开命令行终端(Windows为CMD或PowerShell)。

2、输入“spark-submit”命令,查看帮助信息,确认Spark已正确安装。

3、运行Spark应用程序,如使用Spark Shell进行交互式计算,或使用Spark提供的示例程序。

运行Spark Shell:

1、在命令行终端输入“spark-shell”。

2、Spark Shell启动后,您可以输入Scala或Python代码进行交互式计算。

学习使用Spark

1、访问Apache Spark官网,阅读官方文档了解Spark的基本概念和用法。

2、利用在线学习资源如Udemy、Coursera等学习Spark课程。

3、尝试使用Spark处理实际项目中的数据,积累实践经验。

4、加入Spark社区,与其他开发者交流学习。

进阶使用

1、深入了解Spark核心组件,如RDD、DataFrame、Dataset等。

2、学习使用Spark SQL处理数据。

3、学习Spark Streaming实时数据处理和分析。

4、探索Spark MLlib机器学习库的使用。

5、优化Spark应用程序的性能,如调整参数、数据分区等。

注意事项

1、在安装和配置过程中,请按照步骤操作,避免出错。

2、遇到问题时,可以查看官方文档或搜索相关教程解决。

3、Spark是一个强大的工具,但也需要一定的学习和实践才能熟练掌握。

4、不断更新您的知识,跟进Spark的最新发展,以便更好地使用它处理大数据。

希望本指南能够帮助初学者和进阶用户顺利完成Spark最新版本的安装、配置和使用,通过遵循本指南的步骤,您可以顺利地安装和使用Spark,并深入了解如何使用它处理大数据,祝您在学习和使用Spark的过程中取得进步!